Материалы по тегу: ibm cloud

|

20.11.2024 [13:04], Руслан Авдеев

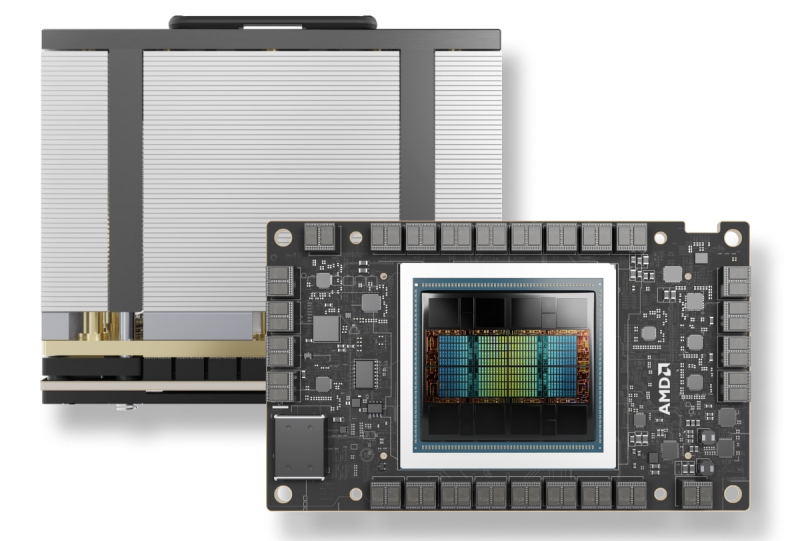

IBM и AMD расширяют сотрудничество: Instinct MI300X появится в облаке IBM CloudКомпания IBM объявила о расширении сотрудничества с AMD для предоставления ускорителей Instinct MI300X в формате «ускорители как услуга» (Accelerators-as-a-Service). По словам IBM, новое решение расширяет возможности и энергоэффективность генеративных ИИ-моделей и HPC-приложений. AMD Instinct MI300X станут доступны в IBM watsonx, а также будут поддерживаться в Red Hat Enterprise Linux AI. Они дополнят портфолио IBM Cloud, уже включающее Intel Gaudi 3 и NVIDIA H100. Ускоритель AMD Instinct MI300X оснащён 192 Гбайт памяти HBM3. И относительно малое количество ускорителей способно обеспечить работу больших ИИ-моделей, что позволяет снизить затраты с сохранением производительности и масштабируемости. Ускорители будут доступны в составе виртуальных серверов и частных виртуальных облаков, а также в контейнеризированных средах IBM Cloud Kubernetes Service и IBM Red Hat OpenShift. Кроме того, для MI300X будут доступны LLM Granite и инструмент InstructLab. Речь идёт в том числе об интеграции программных решений IBM с ПО AMD ROCm. По словам компании, предложенные решения обеспечит клиентов гибкой, безопасной, высокопроизводительной и масштабируемой средой для рабочих нагрузок ИИ. AMD Instinct MI300X станут доступны пользователям IBM Cloud в I половине 2025 года.

30.08.2024 [13:11], Руслан Авдеев

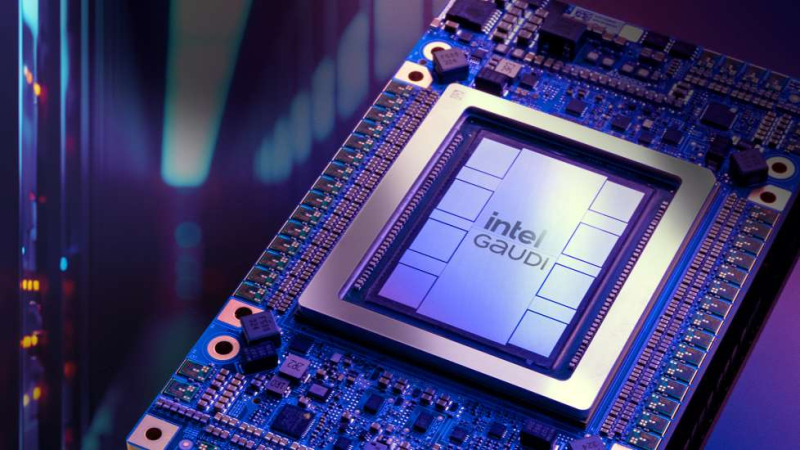

ИИ-ускорители Intel Gaudi 3 дебютируют в облаке IBM CloudКомпании Intel и IBM намерены активно сотрудничать в сфере облачных ИИ-решений. По данным HPC Wire, доступ к ускорителям Intel Gaudi 3 будет предоставляться в облаке IBM Cloud с начала 2025 года. Сотрудничество обеспечит и поддержку Gaudi 3 ИИ-платформой IBM Watsonx. IBM Cloud станет первым поставщиком облачных услуг, принявшим на вооружение Gaudi 3 как для гибридных, так и для локальных сред. Взаимодействие компаний позволит внедрять и масштабировать современные ИИ-решения, а комбинированное использование Gaudi 3 с процессорами Xeon Emerald Rapids откроет перед пользователями дополнительные возможности в облаках IBM. Gaudi 3 будут применяться и в задачах инференса на платформе Watsonx — клиенты смогут оптимизировать исполнение таких нагрузок с учётом соотношения цены и производительности. Для помощи клиентам в различных отраслях, в том числе тех, деятельность которых жёстко регулируется, компании предложат возможности IBM Cloud для гибкого масштабирования нагрузок, а интеграция Gaudi 3 в среду IBM Cloud Virtual Servers for VPC позволит компаниям, использующим аппаратную базу x86, быстрее и безопаснее использовать свои решения, чем до интеграции. Ранее сообщалось, что модель Gaudi 3 готова бросить вызов ускорителям NVIDIA. В своё время Intel выступила с заявлением о 50 % превосходстве новинки в инференс-сценариях над NVIDIA H100, а также о 40 % преимуществе в энергоэффективности при значительно меньшей стоимости. Позже Intel публично раскрыла стоимость новых ускорителей, нарушив негласные правила рынка.

23.05.2024 [21:32], Алексей Степин

Бери да пользуйся: IBM представила частное облако на базе POWER10IBM представила платформу POWER Virtual Server Private Cloud для локального развёртывания частного облака, за обслуживание и корректное функционирование которого отвечает сама IBM. Это решение, по словам компании, позволяет сохранить «ИТ-суверенитет» и избежать существенных финансовых затрат благодаря гибкой ценовой политике. Базовая конфигурация (Small Pod) начинается с 2–4 серверов с 8 Тбайт оперативной памяти, до 340 ядер и до 438 Тбайт пространства для хранения данных. Занимают такие комплекты одну стандартную стойку. Среднего размера «капсула» (Medium Pod) может насчитывать до 40 серверов, в том числе в варианте с 32 Тбайт памяти. Максимальная конфигурация насчитывает 1615 ядер и примерно 3,5 Пбайт дискового пространства.

Источник изображения: IBM В основе платформы лежат серверы IBM POWER S1022 и E1050/1080, использующие процессоры POWER10. Первая система может иметь один или два 20-ядерных процессора с поддержкой SMT8, дополненных 2-4 Тбайт памяти. POWER E1050/1080 поддерживают до четырёх процессоров. Объём памяти в этом случае варьируется в пределах 4–32 Тбайт на сервер. В состав локального облака также могут входить СХД IBM FlashSystem ёмкостью 460 или 920 Тбайт. Сетевые коммутаторы и управляющие серверы входят в стоимость услуги. В качестве базовых ОС доступны Red Hat Enterprise Linux и классические решения IBM — IBM i и AIX. Доступна и сертификация SAP HANA и SAP NetWeaver. Сама услуга предлагается сроком на один год с возможностью возобновления, также доступны трёх- и пятилетние контракты. При этом само оборудование и лицензии приобретать не придётся, платить надо только за их фактическое использование, а сама платформа управляется из IBM Cloud.

09.05.2024 [23:56], Владимир Мироненко

Red Hat представила ИИ-дистрибутив RHEL AI, который требует минимум 320 Гбайт GPU-памяти

ibm

ibm cloud

linux

llm

open source

openshift

red hat

red hat enterprise linux

software

ии

разработка

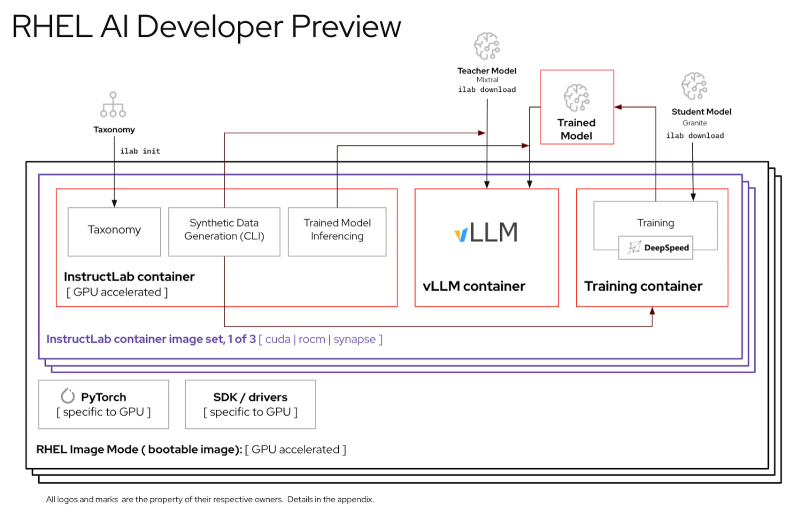

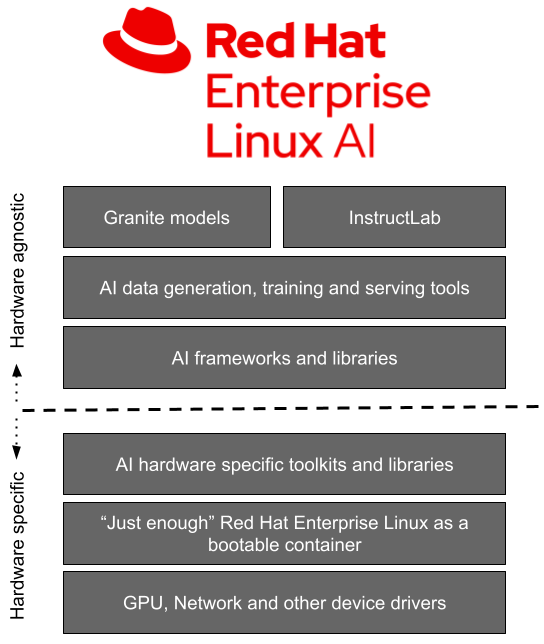

Red Hat представила Red Hat Enterprise Linux AI (RHEL AI), базовую платформу, которая позволит более эффективно разрабатывать, тестировать и запускать генеративные модели искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Фактически это специализированный дистрибутив, включающий базовые модели, инструменты для работы с ними и необходимые драйверы.

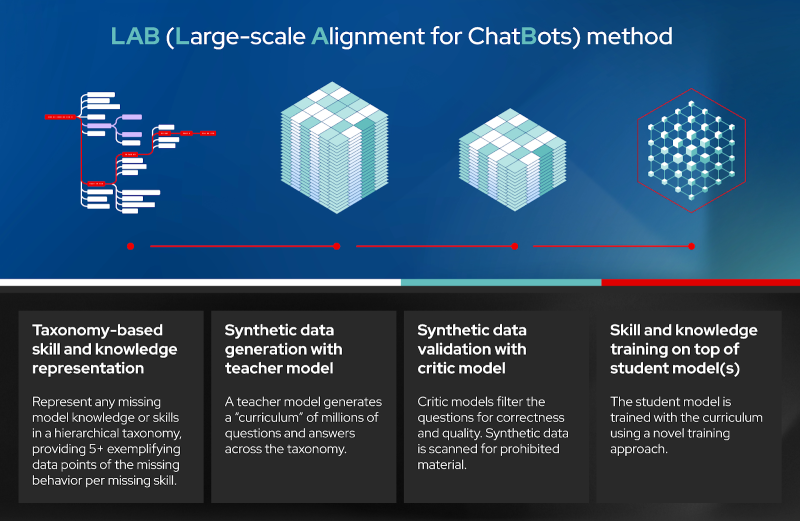

Источник изображений: Red Hat Доступная сейчас в качестве превью для разработчиков, платформа RHEL AI включает в себя семейство больших языковых моделей (LLM) IBM Granite, недавно ставших доступными под лицензией Apache 2.0, инструментом тюнинга и доработки моделей InstructLab посредством методики LAB (Large-Scale Alignment for Chatbots), а также различные библиотеки и фреймворки.  Решение представляется в виде готового для развёртывания образа и является частью MLOps-платформы OpenShift AI. По словам Red Hat, RHEL AI предоставляет поддерживаемую, готовую к корпоративному использованию среду для работы с ИИ-моделями на аппаратных платформах AMD, Intel и NVIDIA. По словам компании, open source подход позволит устранить препятствия на пути реализации стратегии в области ИИ, такие как недостаток навыков обработки данных и финансовых возможностей. Основная цель RHEL AI и проекта InstructLab — предоставить экспертам в предметной области возможность напрямую вносить свой вклад в большие языковые модели, используя свои знания и навыки. Новая платформа позволит им более эффективно создавать приложения с использованием ИИ, например, чат-боты. Впоследствии при наличии подписки RHEL AI компания предложит поддержку корпоративного уровня на протяжении всего жизненного цикла продукта, начиная с модели Granite 7B и ПО и заканчивая возможным возмещение ущерба в отношении интеллектуальной собственности. «Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания. При этом прямо сейчас для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти, а также хранилищем ёмкостью от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel. |

|